資料內(nèi)容:

一、強(qiáng)化學(xué)習(xí)基礎(chǔ)面

1.1 介紹一下強(qiáng)化學(xué)習(xí)?

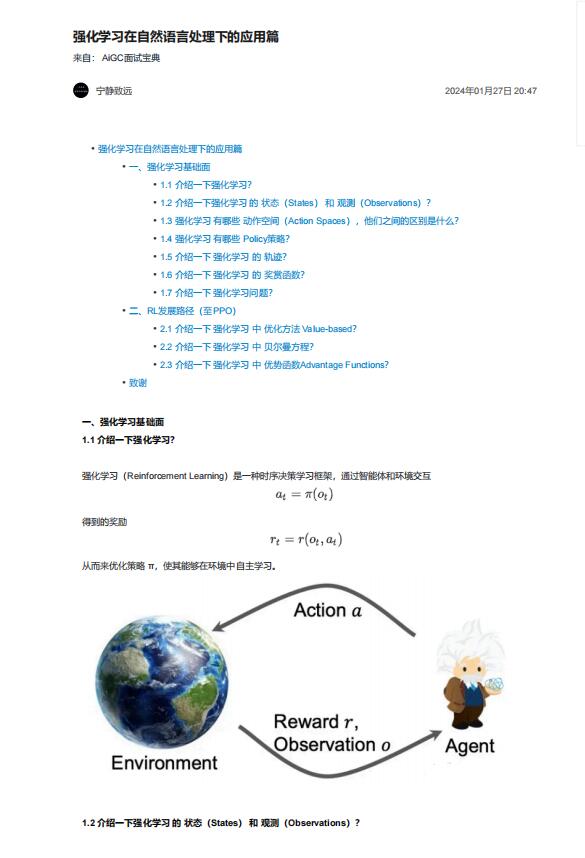

強(qiáng)化學(xué)習(xí)(Reinforcement Learning)是一種時(shí)序決策學(xué)習(xí)框架,通過(guò)智能體和環(huán)境交互

1.2 介紹一下強(qiáng)化學(xué)習(xí) 的 狀態(tài)(States) 和 觀測(cè)(Observations)?

• 狀態(tài)(States):對(duì)于世界狀態(tài)的完整描述

• 觀測(cè)(Observations):對(duì)于一個(gè)狀態(tài)的部分描述,可能會(huì)缺失一些信息。當(dāng)O=S時(shí),稱O為完美信息/fully

observed;O<S時(shí),稱O為非完美信息/partially observed。

1.3 強(qiáng)化學(xué)習(xí) 有哪些 動(dòng)作空間(Action Spaces),他們之間的區(qū)別是什么?

• 離散動(dòng)作空間:當(dāng)智能體只能采取有限的動(dòng)作,如下棋/文本生成

• 連續(xù)動(dòng)作空間:當(dāng)智能體的動(dòng)作是實(shí)數(shù)向量,如機(jī)械臂轉(zhuǎn)動(dòng)角度

其區(qū)別會(huì)影響policy網(wǎng)絡(luò)的實(shí)現(xiàn)方式。

1.4 強(qiáng)化學(xué)習(xí) 有哪些 Policy策略?

• 確定性策略Deterministic Policy: at = u(st),連續(xù)動(dòng)作空間

• 隨機(jī)性策略Stochastic Policy: at ~ π(·|st) ,離散動(dòng)作空間